lm2ei 2025年总结

也学其他人一样,写一份自己的年度总结。这说来还是因为自己有了自己的博客,所以想着能更新和记录一下。

印象深刻的事情

儿子

儿子六周岁了,他比以前大了好多,和当时出生的时候比较真的大了好多。个子高高的,表达方式也不那么稚嫩了。我看到了他的成长,看到了他每天「成功抵抗」自己不想上学的「小心思」;看到了他每天在学校努力的背单词、背古诗的努力;看到了他做数学题的100分,也看到了他在篮球、跳绳方向的天赋。尤其在跳绳方面,他拿到了班级的第一名,而且是三个大班里面的第一名,他非常开心,有着小朋友天真的快乐,最直接的快乐,最纯真的快乐!

媳妇

今年媳妇给做了非常多的好吃的,关心我的健康、关心我的工作、关心我的一切。她陪我一起旅行,她认真的教导孩子的成长教育,她周末忙着自己的工作,她又全心的投入在家庭工作中,例如打扫卫生、洗衣服等等。这些小事、大事、认真的事,每一天的事,都有你,这就是爱情的样子,婚姻最好的样子!

技术分享

今年4月份外出做了一次技术分享,分享公司在领域内的技术进展,与外部的更多人员进行交流探讨。这样的分享是非常不错的,我们不仅仅要向内看满足业务需求,更要向外看,看看大家都在什么位置,大家都在思考什么,像最好的别人学习,成就最好的自己。PS 感谢老板给的机会!

张杰演唱会

第一次参加「巨星」演唱会呀!张杰的歌声真的是太有穿透力了,和媳妇今年5月份一起抢到了票(朋友通过粉丝途径弄到的),现场听了张杰的逆战、天下等等歌曲,也见到了现场有人求婚,真心幸福。祝福~~

海马300

今年8月份去了三亚,和媳妇两个人,去拜拜南海观音,求平安,求阖家幸福。这已经是自己第三次去三亚了,三亚天依旧那么热,也那么蓝。这次在三亚的免税店没有抵制住诱惑,买了欧米茄海马300,自己的第三块机械手表。只能说一个字:帅!

香港旅行

今年和家里人一起去了香港,是在十一国庆节的时候去的,这次旅行非常开心。和媳妇、儿子一起去香港这次旅行,让我感觉非常的舒适、舒服,没有压力,很放松,就是那种非常自然的旅行。在香港办理了港卡、去了迪士尼、也看了香港的繁华和「历史」、更参观了香港大学。

咖啡机

11月份的时候自己在网上本来计划买速溶咖啡,不过,买错了,买成了咖啡豆。自己又不忍心把咖啡豆扔掉,所以又买了一个德龙的咖啡机。嗯,是的,咖啡机比咖啡豆贵很多··不过,非常开心自己的选择,选择的全自动咖啡机,现在基本每天早上自己都会来一杯:一倍浓浓的奶泡加咖啡,让自己的一天满满的幸福和快乐!

工作感想

真的不敢想,因为AI发展太快了。

知识工具

现在经常我自己会产生一种错觉,感觉我什么都会了。因为我什么问题都可以从AI上问到,感觉我自己无所不能,我感觉我自己能知道所有的事情。但是,感觉这是一种错觉,因为我还有很多事情不明白原理,很多事情都是知道皮毛。AI能给你的东西,是你想要知道的某个点,而不是某个面、体。在你感觉自己已经知道的时候,可能你完全还不知道。在你感觉已经看明白的时候,也许只是冰山一角。希望AI不要给我错觉,也不要给大家错觉,我们要做的、要学的还有很多,非常多!

AI提效

AI是有益的,对每个人都是。但是,可能对某些方向是「有害」的。比如工作的消失和裁员。例如翻译这个行业,大体上感觉已经被基本消灭了。大模型翻译的非常好,他能理解上下文,能知道整篇文章的含义,能把一篇文章翻译的非常得体,完全比一个人要翻译的好,这消灭了一个行业。同时,管理者现在看到了AI的「可能性」,感觉一些工作已经不需要更多的人了。比如AICODING方向,管理者要求在这个方向加大投入,不是说这个事情提效了,而是提升人效了。意思是不需要这么多人了,需要减少岗位,公司也减少了很多人。我看到很多头像已经灰色了,不再跳动了。AI的出现,我希望能够增加就业岗位,让大家的生活越来越好,而不是减少就业岗位,让大家越来越卷、越来越焦虑。

AI未来

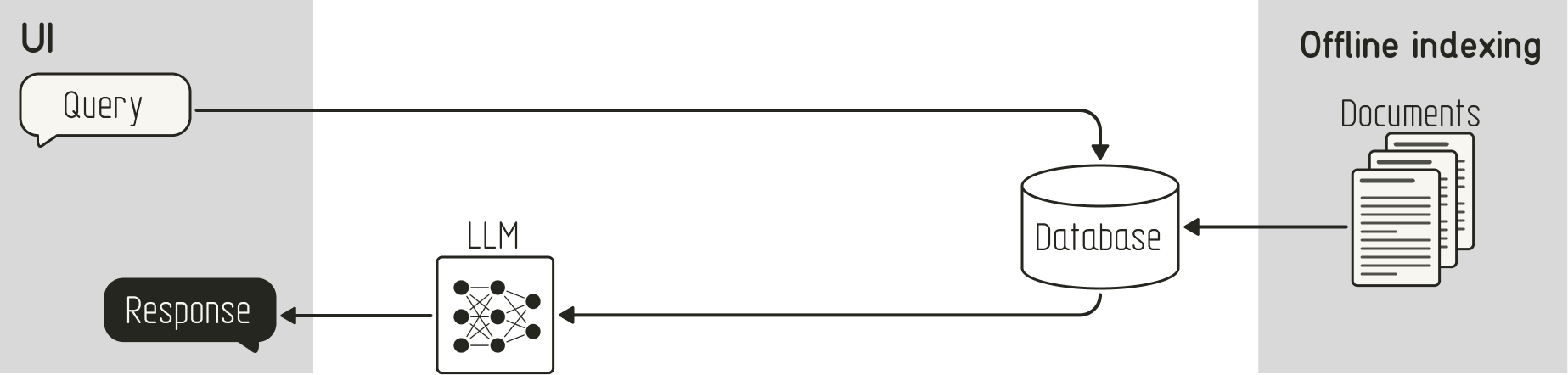

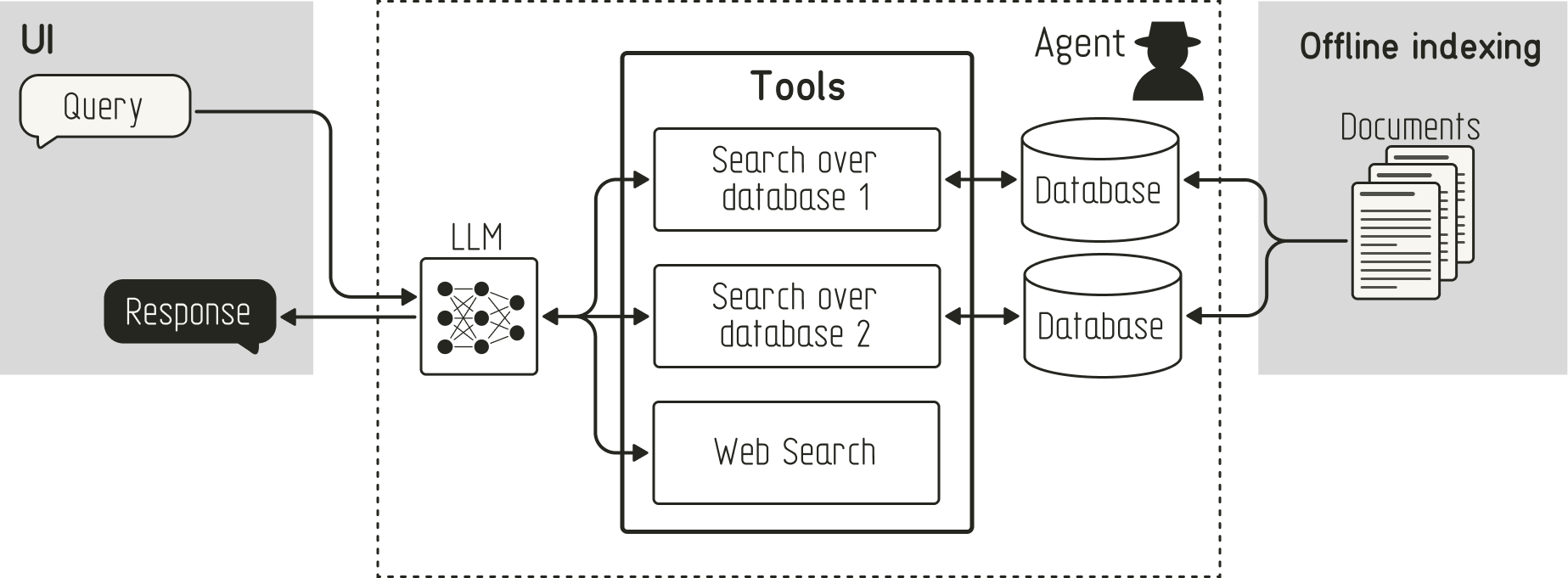

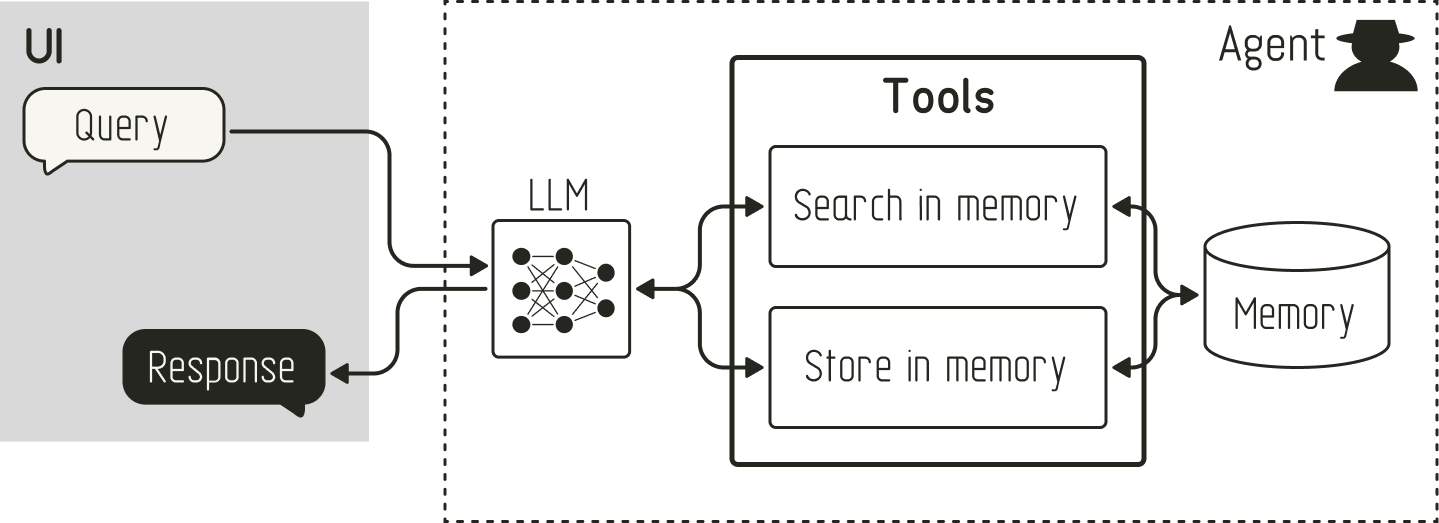

我不知道,我很焦虑,我也在这个方向努力的研究和投入,不想让自己成为「时代的弃子」。AI时代的车轮已经来了,有AGI的模型、有RAG的知识管理、有Agent的智能体,还有很多很多。AI也让很多公司股价大涨,比如NVidia、PLTR、Google等等,这些AI时代的巨头,正在以一种全新的姿态、全新的面貌引领着世界,盈利的同时,也正在让这个世界变得更加美好!

2026年,马上来了,让我们迈入更新的AI时代。不求也不奢望自己成为这个时代的「弄潮儿」,希望自己可以成为这个时代「风口上的猪」就好。

2026,身体健康、阖家幸福。